L’IA et le langage : comment capturer ce qui fait sens ?

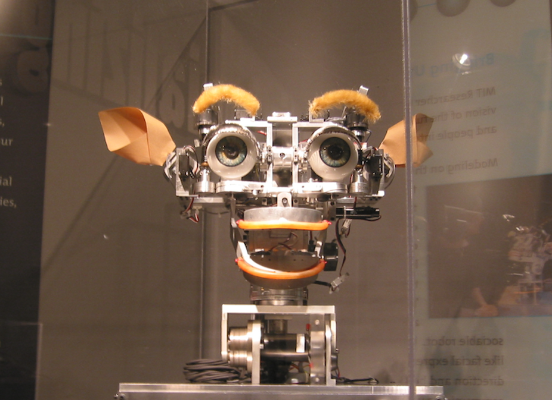

Le robot Kismet robot au musée du MIT. Wikipedia, CC BY-SAParlez-vous l’IA ? NLU, NLG, NLP, ML voire LSTM, TDNN ou GAN, les acronymes qui gravitent autour de la planète IA sont nombreux et souvent abscons.

Le robot Kismet robot au musée du MIT. Wikipedia, CC BY-SAParlez-vous l’IA ? NLU, NLG, NLP, ML voire LSTM, TDNN ou GAN, les acronymes qui gravitent autour de la planète IA sont nombreux et souvent abscons.

Décryptons ici certains d’entre eux dont nous aurons besoin dans cet article : NLU pour Natural language understanding ; ML pour machine learning ; LSTM pour long short-term memory ; TDNN pour time delay neural network.

Ces anglicismes renvoient à des réalités, techniques et technologiques, qu’il est délicat d’appréhender. Qu’elles s’inscrivent dans une série, ou bien au contraire, qu’elles s’opposent en tous points, elles sont « artificielles » dans la mesure où elles tentent de simuler l’intelligence humaine dans ses productions cognitives.

Fondées sur des « recettes » algorithmiques qui permettent de résoudre un problème, ces technologies en appellent à une forme de reproductibilité et non à une compréhension du sens.

Dans le même temps, la planète IA a été bouleversée, ces dernières années, par la montée en puissance de l’« apprentissage machine » ou machine learning. Cela a été rendu possible (et efficace) par des progrès mathématiques avérés et des calculs accélérés au moyen de cartes GPU. Le machine learning optimise les paramètres d’un modèle sur de (très) nombreuses données pour le rendre apte à effectuer des tâches et/ou prendre une décision. Ainsi, l’apprentissage est au cœur des systèmes qui embarquent de l’intelligence artificielle.

Traitement de la parole

Le traitement de la parole est l’un des enjeux passionnants de l’IA. Dans ce champ de recherche, l’essor des technologies de natural language understanding semble directement lié aux progrès du machine learning, et notamment des technologies d’apprentissage profond, dites deep learning. Pourtant, plus qu’une réelle compréhension de la parole, il s’agit d’abord et avant tout d’essayer de circonscrire, de cartographier le sens plus que d’en saisir la « substantifique moelle ».

Plus qu’une capture du sens, c’est bel et bien le rapport signifié-référent que l’on cherche à appréhender en utilisant les signifiants et leurs rapports en contexte.

Pour éclairer cette problématique, quelques bribes d’histoire. Le Test de Turing, tel que décrit par son inventeur dès 1950, montre que la notion d’imitation est fondamentale : on peut effectivement parler d’« intelligence artificielle » quand la machine est capable de dialoguer avec un humain sans que celui-ci ne se rende compte de la supercherie. Ce test, dont la validité n’a depuis pas été détrônée, a permis l’avènement des premiers systèmes de dialogue.

Malheureusement, ces tentatives ont rapidement tourné court car l es systèmes de transcription de la parole (dorénavant Système de reconnaissance automatique de la parole ou SRAP) qui devaient offrir la matière langagière en entrée n’étaient pas au point. Trop incertains et erratiques, ils n’étaient pas suffisamment fidèles aux propos tenus, sauf à « tricher » en ayant recours à la ruse dite du magicien d’Oz où un humain simule une voix de robot pour poursuivre l’échange (WOZ pour Wizard of OZ)…

L’agent conversationnel Tay sur Twitter. YouTube

L’agent conversationnel Tay sur Twitter. YouTube

Il aura fallu attendre cette dernière décennie pour que les chatbots et autres callbots (un robot capable de « dialoguer » via le téléphone) réintroduisent la notion de dialogue en IA et, à travers elle, celle d’interactions, entraînant de facto un regain d’intérêt pour les SRAP et pour la compréhension du langage.

Toutefois et bien qu’ils président à l’avènement des technologies de NLP, les SRAP n’essaient pas, eux non plus, de capturer du sens. Ils se contentent de faire correspondre à un flux audio (des paroles entrecoupées de bruits et autres musiques) une chaîne de caractères (des mots voire des presque-mots et autres disfluences comme les euh, heu, bah, ben, si caractéristiques du français, notamment à l’oral).

Mais alors que la transcription de la parole n’entre pas directement dans le spectre des tâches de NLP, la traduction, quant à elle, y figure en bonne place.

Alors quid de la quête du sens ? Pourquoi ne pas considérer une sortie de SRAP comme du NLP alors qu’on a tendance à la faire avec un énoncé traduit par un système automatique ?

À la poursuite du sens

Les systèmes de traduction ont pour objectif de photographier un état de la langue source pour le faire correspondre à la langue cible, à travers des corpus parallèles, ou faute de mieux, des corpus comparables. Cette gymnastique n’a pas attendu l’émergence de la technologie des réseaux de neurones profonds, le système Moses en est la preuve. Éminemment probabiliste, ce dernier était fondé sur une traduction par séquences de mots. Là encore, il s’agissait de modéliser, via un apprentissage, les événements langagiers observés pour mieux procéder ensuite à un réordonnancement des mots dans la langue cible. Ce qui était auparavant travail ciselé d’experts en linguistique pour retrouver les fondamentaux morphosyntaxiques et lexicaux partagés est donc devenu avec les statistical machine translation, « simple » correspondance mathématique. Se pose à nouveau la question de la quête du sens dans cette entreprise…

Pour beaucoup, la clé réside dans un effort d’analyse supplémentaire qui tendrait à circonscrire le sens de l’énoncé produit.

Ainsi, les tâches de résumé automatique, d’indexation documentaire mais aussi de classification thématique (y compris le binaire et manichéen spam or not spam ?) semblent réussir à savoir « de quoi ça parle ». Toutefois, comme pour la transcription, il s’agit surtout, après normalisation, de comptabiliser les événements les plus observés et leurs co-occurrences. Ces dénombrements n’ont d’autre but que de concourir, non pas à la quête du sens, mais, à la recherche d’une relation inter-signifiants et des réseaux qui s’établissent par l’usage.

Qu’elle soit ou non terminologique, une langue est d’abord et avant tout le fait de ses locuteurs.

Aujourd’hui, le regain d’intérêt autour des réseaux de neurones, du fait de l’aptitude mathématique nouvellement gagnée à empiler les couches, et donc à emmagasiner les connaissances et les informations additionnelles, permet de dessiner des architectures où l’on tente, de manière multimodale, de capturer ce qui fait sens. Mais ces réseaux, qu’ils embarquent des portes d’oubli et de mémoire (les long short-term memory) ou qu’ils jouent avec la temporalité (les time delay neural network), ne sont pas aptes à « comprendre » et donc à véritablement restituer le sens d’un énoncé.

Ils sont fondés sur la nécessité de capter les proximités plus ou moins lointaines pour mieux retenir l’essentiel : l’usage.

Arrêtons-nous quelques instants, non sur la syntaxe de la langue mais sur les mots.

En se focalisant sur ces petites unités du langage, l’objectif est alors de mieux appréhender leur sémantique, c’est-à-dire les mécanismes propres à la construction du sens. Ainsi, en construisant avec des réseaux de neurones appropriés et des données idoines, des word embeddings, on se donne l’illusion de faire émerger le sens, de permettre aux systèmes, qu’ils soient de traduction ou de NLP de se doter d’une brique de compréhension.

Pourtant, les word embeddings ne résultent que d’un effort de vectorisation : il s’agit de représenter les mots les plus fréquents d’un vocabulaire par un vecteur de nombres réels continus dont la dimension a été choisie à dessein. Cette « traduction » numérique du mot permet de le positionner par rapport aux autres dans le vocabulaire dessiné. Pour autant, ce qui se rapporte à une construction du sens, n’est que reproductibilité apprise par l’encodeur et correctement décodée à l’issue de la chaîne de vectorisation.

La question de la capture du sens par un système se fait particulièrement prégnante avec l’intérêt croissant porté au deep learning, compte-tenu notamment de la puissance accrue qu’offrent ces technologies.

Mais au-delà même d’une appréhension du sens, il s’agit d’abord et avant tout d’encoder alpha numériquement l’usage, à travers un apprentissage plus ou moins conséquent, ciselé ou non, et de le décoder pour l’utiliser dans un cas d’usage qui fait sens pour l’utilisateur.

Auteur : Paul Deléglise - Professeur émérite, spécialiste du Traitement Automatique de la Parole au Laboratoire d'Informatique de l'Université du Mans

Carole Lailler, docteur en sciences du langage et experte de la société Scribe-Conseil et Olivier Mégean, président de la société demain.ai ont co-écrit cet article avec Paul Deleglise.

Cet article est republié à partir de http://theconversation.com sous licence Creative Commons. Lire l’article original.

L’IA et le langage : comment capturer ce qui fait sens ?

The Conversation